Tutti parlano dei chatbot, le nuove applicazioni dell’intelligenza artificiale in grado di simulare una conversazione e rispondere all’utente attingendo al patrimonio sconfinato dello scibile online. Sono sistemi basati sugli Llm, o Large Language Models, la cui popolarità è esplosa quando la società Open AI, di San Francisco, ha reso disponibile gratuitamente ChatGPT stuzzicando milioni di utilizzatori a testare le capacità del sistema.

Gli scienziati lo hanno usato per facilitare il lavoro di ricerca, ma ChatGPT è in grado di scrivere un testo di qualità accettabile rispondendo a qualsiasi domanda e può essere utilizzato da chi sappia poco o nulla di una materia per superare test scolastici, giusto per fare esempi che stanno scuotendo il mondo dell’editoria scientifica e delle università.

LEGGI ANCHE: “Google, Alibaba e le altre: quali aziende stanno lavorando a un rivale di ChatGPT”

I problemi di ChatGPT

Dopo che ChatGPT è apparso nella lista degli autori di diversi lavori scientifici, che ne avevano sfruttato le capacità ora integrate nel motore di ricerca Bing di Microsoft, gli editori delle maggiori riviste si sono trovati di fronte a un problema. Tutti insieme hanno deciso che è una pratica non accettabile visto che ogni autore deve assumersi la responsabilità del contenuto dell’articolo e ChatGTP non ha un’opinione propria, ma solo un coacervo delle opinioni che ha letto. In più, qualora ci fossero contestazioni, chi ne risponderebbe davanti a un giudice? Chi ha usato il sistema sostiene sia molto utile per migliorare lo stile di scrittura e per trovare referenze, sfruttandolo a mo’ di ottimo servizio di segreteria. In parallelo, le università si chiedono come distinguere i testi scritti dagli studenti da quelli dei chatbot e, sapendo non sarà facile, cercano di attrezzarsi.

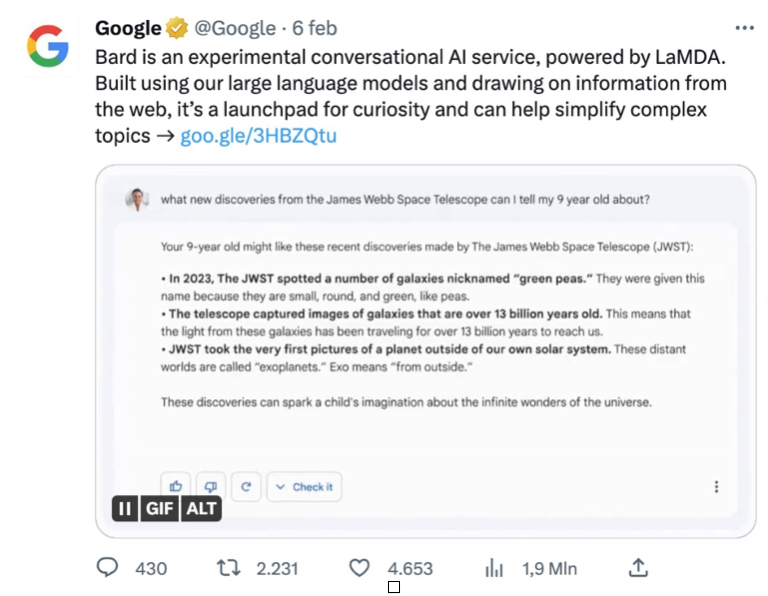

L’errore “miliardario” di Bard

Ovviamente, i grandi del web non possono permettersi di restare indietro e investono miliardi per costruire un loro sistema di AI da offrire ai clienti. Google si è affidato alla proprietaria Alphabet, che ha sviluppato il sistema Bard; questo, pur essendo ancora in fase sperimentale, ha già causato un grosso problema. Infatti, durante l’evento inaugurale, Bard è incappato in un errore che ha causato una caduta rovinosa del titolo di Google, una perdita del 7% equivalente a oltre un centinaio di miliardi di dollari.

Ovviamente la cosa ha attirato l’attenzione della comunità scientifica, visto che Bard è scivolato su una domanda di astronomia. Davanti a qualcuno che chiedeva “Cosa posso dire a mio/a figlio/a di 9 anni del James Webb Space Telescope?”, Bard ha suggerito tre argomenti: i primi due, l’osservazione delle galassie verdi come piselli e l’osservazione di galassie molto antiche, sono corretti, ma la terza affermazione, quella in cui Bard sostiene che JWST abbia ottenuto la primissima immagine (very first picture) diretta di un esopianeta, è sbagliata. Clamorosamente sbagliata. La prima immagine diretta di un pianeta extrasolare in orbita intorno alla sua stella è stata ottenuta dal Very Large Telescope dello European Southern Observatory (o Eso) nel 2004.

Un errore su un tema astronomico molto specifico, forse causato da una interpretazione fallace del titolo di un articolo sui dati del telescopio spaziale pubblicato da Nature, in cui si menziona la “prima immagine di un pianeta extrasolare”, ma circoscrivendola all’attività specifica di James Webb Space Telescope, e non intendendo la prima immagine in assoluto.

Come professore di astronomia al terzo anno del corso di laurea in fisica all’Università di Pavia, mi sono chiesta quale sarebbe stata la mia reazione a una affermazione di questo tipo fatta da qualcuno/a dei miei studenti. Forse avrei inarcato un sopracciglio chiedendo sicuro/a? Non è che l’ha fatto qualcuno prima? Ma non l’avrei considerato un errore catastrofico. Assicuro di averne sentiti di peggiori.

Evidentemente sono più “generosa” degli investitori, che non hanno perdonato l’imprecisione di Bard e hanno fatto crollare il titolo Google in Borsa come non era mai successo. Perdita tanto più bruciante se si considera che ChatGPT, che non è certo infallibile, ha fatto salire del 4,2% le azioni di Microsoft, che ha investito dieci miliardi di dollari in Open AI, una società creata nel 2015 da Elon Musk e da Sam Altman, attuale ceo.

La necessità di un controllo

Sembra evidente che a contare, in un sistema di AI, non sia l’entità dell’errore, ma il fatto di averne commesso uno facilmente riconoscibile, quindi evitabile. Mettere in dubbio la correttezza di un’informazione fornita da un chatbot implica la necessità di un controllo – che da professoressa consiglio comunque – e quindi pregiudica l’affidabilità e l’utilità di un sistema.

Considerando che il James Webb Space Telescope è costato più di dieci miliardi di dollari, la perdita subita da Google equivale al costo di dieci supertelescopi. La clamorosa scivolata di Bard ha ricordato la disavventura di Elon Musk quando, nel 2019, durante la presentazione del pickup truck elettrico di Tesla, ne ruppe un finestrino dopo averlo spacciato per infrangibile (caratteristica peraltro del tutto inutile alla funzionalità del mezzo). Anche in quel caso, gli investitori non apprezzarono e il giorno successivo il titolo Tesla perse il 6,3%. Una disavventura, tuttavia, non in grado di fermare il Cybertruck, atteso sul mercato entro il 2024.

Il mercato dell’intelligenza artificiale

Allo stesso modo, il costoso errore astronomico non fermerà Bard, perché l’intelligenza artificiale è qui per restare: muove un mercato globale che dovrebbe superare i 190 miliardi di dollari nel 2023 e crescere fino a 1,8 trilioni nel 2030. Dovremo imparare a sfruttare i pregi dell’AI, ma anche evitare di creare una generazione che risponda alle domande attraverso i chatbot senza darsi la pena di studiare.

Il pericolo è concreto: ChatGPT ha quasi superato l’esame di abilitazione richiesto ai medici statunitensi per poter esercitare la professione. In un batter d’occhio, il chatbot ha dato il 60% delle risposte esatte, ottenendo un punteggio quasi sufficiente per superare un esame che richiede anni di preparazione. Un dato che ricorda come anche ChatGPT sbagli una frazione delle risposte, ma in modo meno eclatante del concorrente di Google.

Per altri contenuti iscriviti alla newsletter di Forbes.it CLICCANDO QUI .

Forbes.it è anche su WhatsApp: puoi iscriverti al canale CLICCANDO QUI .