Per la prima volta, è possibile generare un discorso articolato da intere frasi estrapolate dall’attività cerebrale di un individuo. Un’autentica rivoluzione che potrà stravolgere la vita di tutte quelle persone che hanno perso l’uso della parole a causa di paralisi, malattie come il cancro alla gola e patologie neurodegenerative come la SLA e il morbo di Parkinson.

L’esempio di Stephen Hawking

Fino ad ora infatti, le persone affette da queste patologie hanno comunicato grazie ai sintetizzatori vocali che utilizzano sistemi text-to-speech (TTS) cioè “da testo a voce”. Un esempio noto è quello di Stephen Hawking, scomparso lo scorso anno. Dal 1997 infatti Intel ha fornito all’astrofisico affetto da SLA la tecnologia per permettergli di parlare: Hawking poteva inizialmente digitare con le proprie mani le parole da pronunciare ma, con l’aggravarsi della patologia, sono state necessarie nuove tecnologie come Acat (Assistive Context-Aware Toolkit), basata sul movimento del muscolo della guancia, l’unico che lo scienziato era in grado di controllare negli ultimi anni di vita.

Questo sistema permetteva ad Hawking di svolgere anche altre mansioni, come navigare sul web, controllare la posta elettronica e collegarsi su Skype. Hawking si prestò anche ad un esperimento per sviluppare una tecnologia basata sulla scansione dell’attività cerebrale attraverso degli elettrodi. I segnali elettrici tuttavia si rivelarono troppo deboli per poter essere identificati e utilizzati per la scelta delle lettere. Lo scienziato di Cambridge sarebbe stato entusiasta di sapere che la scienza è riuscita a compiere quel passo.

I progressi scientifici dell’interfaccia brain-machine

“Per la prima volta possiamo generare intere frasi sulla base dell’attività cerebrale di un individuo. Con una tecnologia che è già a portata di mano, dovremmo essere in grado di costruire un dispositivo clinicamente valido per pazienti che hanno perso l’uso della parola” – lo ha spiegato Edward Chang, professore di chirurgia neurologica all’Università della California di San Francisco (UCSF) e lead author della ricerca pubblicata sulla prestigiosa rivista “Nature”.

Per raggiungere lo scopo, i ricercatori si sono dedicati a quelle aree del cervello che inviano le istruzioni necessarie per coordinare la sequenza dei movimenti della lingua, delle labbra, della mascella e della gola necessari per articolare un discorso: “Abbiamo pensato che se questi ‘centri vocali’ nel cervello codificano i movimenti piuttosto che i suoni, avremmo dovuto cercare di fare lo stesso nel decodificare i segnali” – ha aggiunto il ricercatore Gopala Anumanchipalli.

Come funziona il nuovo decodificatore

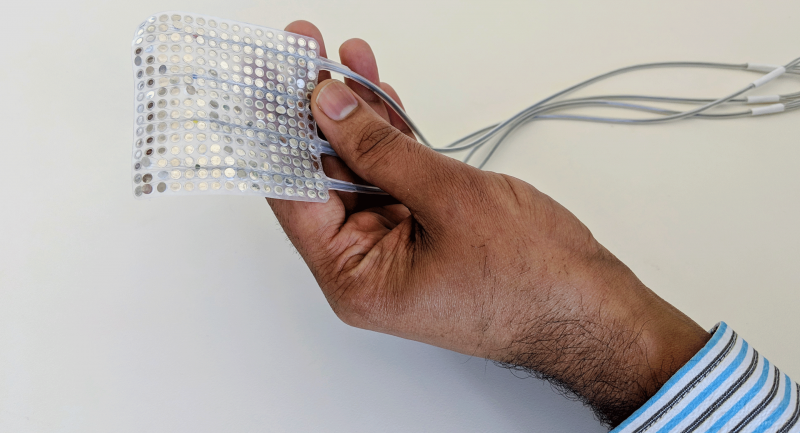

Un lavoro arduo se si pensa alla velocità, sottigliezza e complessità dei movimenti che le persone compiono durante il discorso; i ricercatori così hanno pensato bene di operare in due fasi: tradurre i segnali elettrici nel cervello in movimenti e poi tradurre quei movimenti in suoni. L’algoritmo di apprendimento automatico utilizzato è stato “addestrato” affinché fosse in grado di associare i modelli di attività elettrica nel cervello con i movimenti vocali come stringere le labbra insieme, racchiudere le corde vocali e spostare la punta della lingua sul palato. La tecnologia in questione si chiama “virtual vocal tract” e il risultato attuale è una voce umana piuttosto normale ma con un forte accento straniero.

Per testare il sistema gli scienziati hanno coinvolto un vasto gruppo composto da qualche centinaio di persone chiedendo loro di ascoltare i discorsi sviluppati dall’algoritmo, attraverso la piattaforma di Mechanical Turk di Amazon, e di trascrivere le frasi (100 frasi e un pool di 25 parole da selezionare ogni volta, incluse le parole target e quelle casuali). I partecipanti al test hanno trascritto le frasi perfettamente il 43% delle volte e gli scienziati hanno rivelato come alcuni suoni, ad esempio “sh” e “z”, siano stati perfettamente sintetizzati e pronunciati correttamente mentre per altri, come “b” e “p”, ci sarà ancora da lavorare. Imperfezioni che però “non rappresentano grosse difficoltà”, spiegano entusiasti i ricercatori incoraggiati anche dal fatto che l’algoritmo è stato in grado di sviluppare nuove frasi di senso compiuto sulle quali non era stato addestrato.

Per altri contenuti iscriviti alla newsletter di Forbes.it CLICCANDO QUI .

Forbes.it è anche su WhatsApp: puoi iscriverti al canale CLICCANDO QUI .